目录

目录

神龙MoC卡

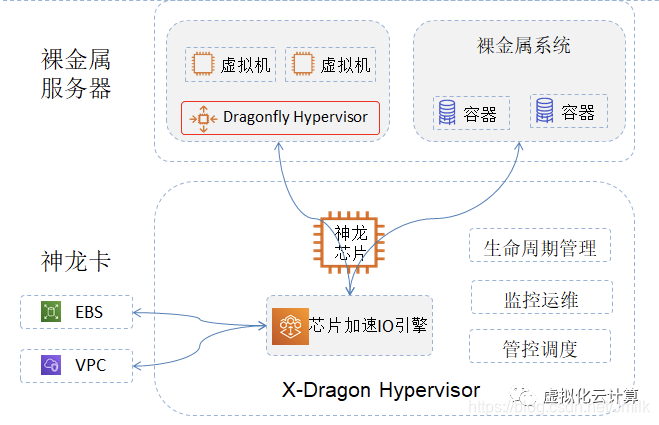

2017年,阿里云推出了第一代自研神龙服务器,搭载了自研的MoC(on Chip)卡。MoC卡的能力也随着神龙架构的演进不断迭代更新:

神龙1.0:解决了上云之后如何支持裸金属服务的问题,将云上组件特别是裸金属管理模块卸载到MoC卡上,提供裸金属的弹性交付和运维;神龙2.0:神龙芯片能力进一步增强,通过轻量构建实现计算虚拟化卸载,支持虚机服务;神龙3.0:通过DPU芯片硬件对存储、网络等数据平面路径进行充分优化,性能大幅提升,可以提供接近裸金属的低延迟网络;神龙4.0:集成弹性RDMA能力,让RDMA从HPC应用走向支持通用计算场景。

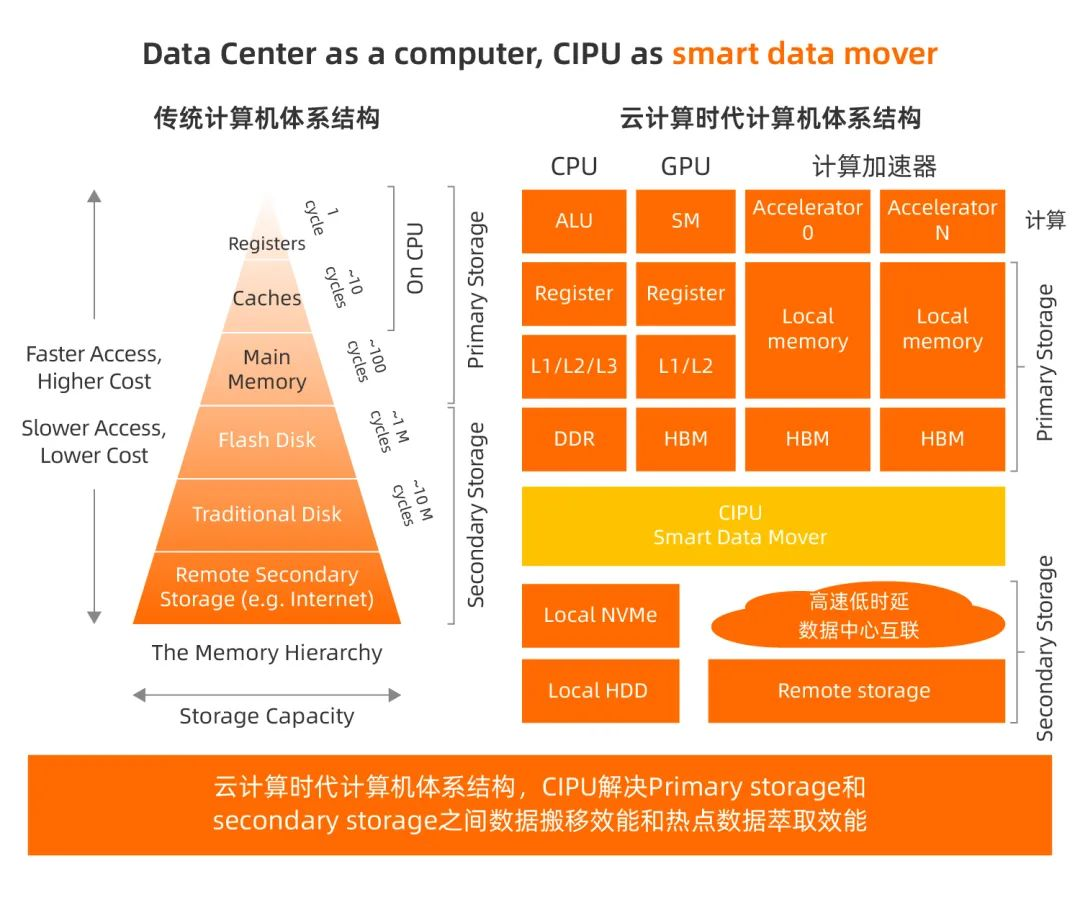

以MoC卡为原型,阿里云于2022年6月发布云数据中心专用处理器CIPU,声称将成为云时代IDC的处理核心。

中央太平洋大学

相比传统厂商,云计算巨头完全是为了满足自己的云计算需求,在他们看来,它是一个完整的计算、存储、网络一体化处理单元,至于具体业务怎么分担,只有云厂商自己才知道。

因此对于云厂商来说,自研似乎才是正道,“智能网卡”这个概念已经非常薄弱,它已经不单单是一块网卡,而是深深融入到了他们的血液之中。

2017年,阿里云开始部署完全自研的X-MOC卡。

2022阿里云峰会上发布了云数据中心专用处理器CIPU(Cloud Units,云基础设施处理器),是针对IDC计算、存储、网络基础设施云化,硬件加速的专用业务处理器。

CIPU的定位

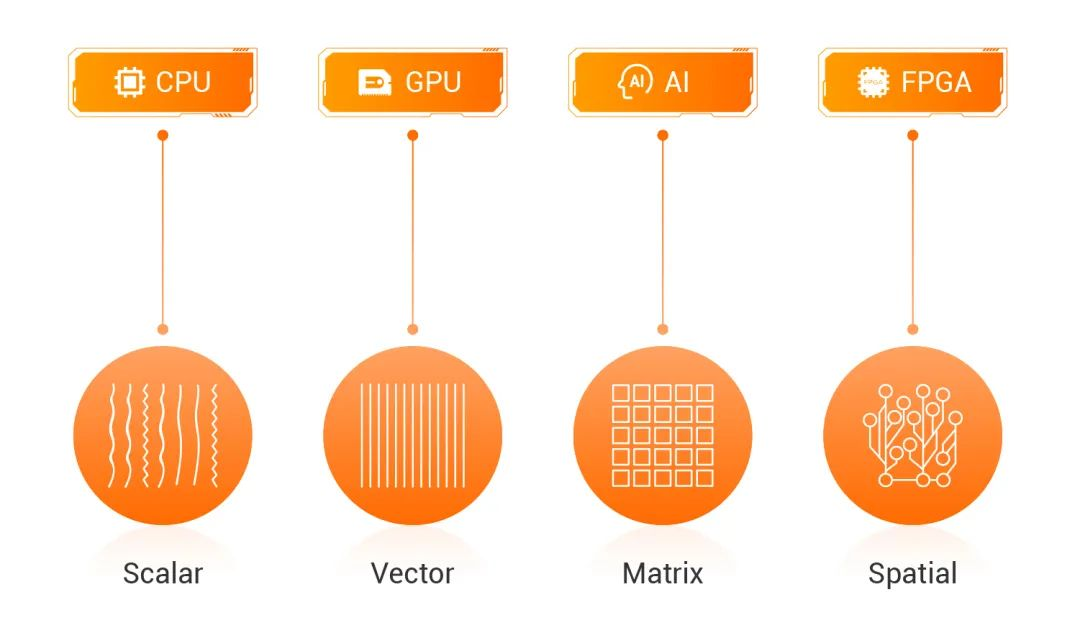

CIPU在通用标量计算、AI矢量计算等业务领域达到XEON ALU、GPU的算力显然不现实。适合CIPU的业务类型共同业务特点:在数据流动(移动)过程中,通过深度垂直软硬件协同设计,尽可能减少数据移动,提高计算效率。

因此从计算机体系结构角度CIPU的主要工作是优化云计算服务器之间、服务器内部的数据分级缓存、内存、存储的访问效率。

CIPU路径上异构计算(位于网络和存储必经的路径上)=近网络计算(位于 )+近存储计算(位于 )

CIPU IO硬件设备虚拟化的10大能力

通过VT-d前端支持技术实现高性能IO硬件设备虚拟化。

考虑到公有云OS生态的兼容性,设备模型尽量做到兼容,因此需要基于-net、-blk、NVMe等业界标准实现IO设备模型。

同时还要兼顾IO设备的高性能,因此PCIe协议层面的优化至关重要。如何减少PCIe TLP通信量、减少Guest OS中断次数(同时平衡延迟要求)、实现灵活的硬件队列资源池化、新增IO服务可编程可配置的灵活性是决定IO硬件设备虚拟化好坏的关键。

VPC 硬件加速

网络虚拟化的业务需求是:

传统解决方案面临的挑战:

+大带宽数据移动导致“冯·诺依曼内存墙”问题突出;网络虚拟化业务CPU标量处理并行瓶颈明显;基于软件的数据路径处理难以克服时延抖动。

此时硬件转发加速的业务需求显现,技术实现层面可分为:

EBS分布式存储访问硬件加速

公有云存储需要实现9个9的数据持久化,计算和存储需要满足弹性的业务需求,必然导致存储和计算的分离,EBS(阿里云块存储)必须连接机尾的分布式存储,机头的高性能、低延迟。

具体需求层次:

EBS作为实时存储,必须实现E2E极低延迟和极P9999延迟抖动;实现线速存储IO转发,比如在网络环境下实现6M IOPS;以及新一代NVMe硬件IO虚拟化,在解决PV NVMe半虚拟化IO性能瓶颈的同时,满足共享盘的业务需求。本地存储虚拟化硬件加速

本地存储虽然不具备EBS那种九个九的数据持久性和可靠性,但在低成本、高性能、低延迟等方面依然具有优势,是计算缓存、大数据等业务场景的刚需。

如果实现了本地磁盘虚拟化,那么带宽、IOPS、延迟的零衰减,结合一对多的虚拟化、QoS隔离能力、可维护性,将是本地存储虚拟化硬件加速的核心竞争力。

弹性 RDMA

RDMA网络在HPC、AI、大数据、数据库、存储等数据业务中发挥着越来越重要的技术作用,可以说RDMA网络已经成为数据业务差异化能力的关键。

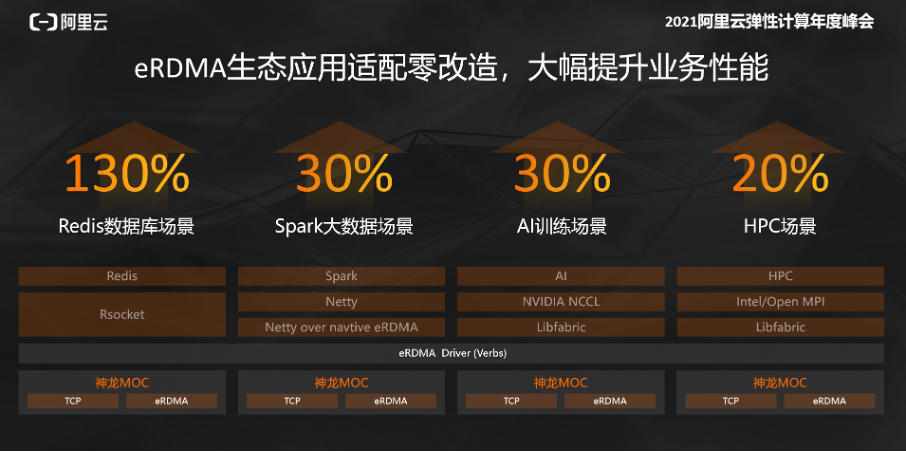

eRDMA能力可以应用于HPC、AI、数据库、大数据等多种场景,让RDMA成为通用的网络基础设施。

包括的

eRDMA 依托阿里云神龙架构 MoC 卡,结合通用服务器和交换机、私有协议实现 RDMA,由于取代了专用的网络交换机和网卡设备,因此性价比高,不需要购买昂贵的设备或者搭建专用网络。

高性能

eRDMA 可以提供最低 5 微秒的延迟,优于同类技术方案(AWS 的 EFA 为 15.5 微秒),虽然比基于实现的 RDMA 方案高出几微秒,但比原有 VPC 的 25 微秒降低了约 80%。 从而让数据库、AI、大数据等应用获得了 30% 到 130% 的性能提升(Redis 数据库性能提升 100%,AI 训练性能和大数据性能提升 30%)。

值得强调的是,eRDMA 最低 5 微秒的延迟是在单 AZ(可用区)网络中的表现,当然如果网络跨地域,延迟会有所增加,但实际上跨地域网络部署应用的情况并不多见,因此 5 微秒的延迟更有实际的参考价值。

大规模组网

常见的RDMA实现方案有RoCE和iWARP网络(iWARP比较少见),虽然这两种方案在性能上比eRDMA要好,但是都依赖于昂贵的专用网络设备,尤其是具备优先级流控能力的交换设备,运维成本也比较高,更重要的是这两种方案都无法实现大规模组网。

eRDMA具有很强的扩展性,它突破了传统RDMA实现方案中大规模组网的问题,传统组网方案中一台交换机只能支持三四百台设备,而eRDMA可以通过大规模组网构建更大规模的计算集群。

技术实现方面,阿里云eRDMA采用自研的HPCC拥塞控制算法,可以容忍VPC网络中传输质量(延迟、丢包等)的变化,在有损网络环境下依然有良好的性能。

虽然TCP/IP也能达到RDMA所要求的可靠性,但却是以延迟为代价的,而eRDMA的技术突破在于,它提供了与TCP/IP类似的可靠性,同时还拥有出色的延迟性能。

弹性

eRDMA简单易用,一端连接用户熟悉的VPC网络,可以利用VPC提供的各种功能特性连接各类云资源,获得资源弹性。

RDMA在云端可用,随用随用,无需长期部署。基于云网络的大规模部署,哪里有网络,哪里就能通RDMA网络。

RDMA 动词生态系统 100% 兼容

另一方面,eRDMA提供的ERI(RDMA)接口也充分参考了RDMA上流行的验证接口,对接了开放的生态。

eRDMA支持原生Verbs接口的应用,实现了无缝支持上层应用享受RDMA带来的性能收益,并且整体性能得到了显著提升,即便是Spark、Redis等数据库应用在无需太多修改的情况下,性能也有了显著提升。

人工智能/机器学习

说到大规模集群的应用场景,就不得不提到机器学习训练场景。

阿里云在过去几年服务AI场景的实践表明,主要从网络加速层面优化机器学习训练流程,而不是优化机器学习框架和模型层面。通过AIACC加速引擎优化机器学习训练集群的通讯效率,提升云上机器学习训练的效率。

安全硬件加速

不断强化硬件可信技术、VPC东西向流量全加密、EBS及本地盘虚拟化数据全加密、基于硬件的技术是云厂商不断提升云服务竞争力的关键。

云运维能力支持

云计算的核心是(面向服务),让用户无需运维就能运维IT资源。IaaS弹性计算与运维能力的核心是:

弹性裸机支持

弹性裸机在具体定义层面必须实现以下八个关键业务特性。同时,云计算弹性业务必然需要弹性裸机、虚拟机、安全容器等计算资源的池化和调度。

CIPU 池化能力

考虑到通用计算和AI计算在网络、存储、算力等方面的要求存在巨大差异,CIPU必须具备池化能力。通用计算可以通过CIPU池化技术大幅提高CIPU资源利用率,从而在成本层面提高核心竞争力;同时可以在一套CIPU技术架构体系下满足AI等高带宽业务的需求。

计算虚拟化支持

随着计算虚拟化、内存虚拟化等业务特性的增强,云厂商会对CIPU定义很多核心需求。

扫一扫在手机端查看

- 上一篇:脚本是啥_php的4种常见运行方式

- 下一篇:脚本是干什么的_什么是PHP编程开发?

我们凭借多年的网站建设经验,坚持以“帮助中小企业实现网络营销化”为宗旨,累计为4000多家客户提供品质建站服务,得到了客户的一致好评。如果您有网站建设、网站改版、域名注册、主机空间、手机网站建设、网站备案等方面的需求,请立即点击咨询我们或拨打咨询热线: 13761152229,我们会详细为你一一解答你心中的疑难。

客服1

客服1