蜘蛛,又称网络爬虫、网络机器人,是按照一定策略不断抓取互联网网页的特定程序。 蜘蛛爬回的页面被索引并排名,等待用户检索。 为了优化网站自然排名首页,Elf 下面详细分析一下原理。

蜘蛛分类

目前,互联网上的蜘蛛根据其功能和特点主要可以分为四类:批量蜘蛛、增量蜘蛛、垂直蜘蛛和深网蜘蛛。

1. 批量蜘蛛

这类蜘蛛有明确的爬行范围和目标。 它通常从一个特定的任务开始,用于批量收集指定的数据项。 达到预定目标后就会停止。 数据收集工具或程序就是这种类型的蜘蛛。

2.增量蜘蛛

这种蜘蛛不限制爬行范围和目标,不断地爬行。 增量蜘蛛的增量有两个方面,一是爬取尽可能多的网页,二是爬取已经爬取过的网页。 再次获取并更新。

还有一个术语“万能蜘蛛”。 业界对这种蜘蛛有两种定义,都是无休止地抓取网页。 它们之间的区别在于是否包含增量更新。 如果是这样,它们就与增量蜘蛛相同。 。

3. 垂直蜘蛛

也称为聚焦蜘蛛,此类蜘蛛抓取指定类型的内容,其覆盖范围不如一般增量蜘蛛那么广。 可以说是增量蜘蛛的一个具体子类。 淘宝搜索、优酷搜索、微信搜索等蜘蛛都是垂直蜘蛛。

4.深网蜘蛛

在互联网中,存在大量与表面网络解耦的网页。 普通蜘蛛无法爬行这些页面。 它们就是“暗网”。 其他需要注册登录的页面无法被蜘蛛抓取。 目前,各种网页都无法被蜘蛛抓取。 搜索引擎正在努力自己抓取这些内容,这就是深网蜘蛛。 目前获取暗网数据的主要思路仍然是通过开放平台提交数据,如“百度站长平台”、“百度开放平台”等。

大型搜索引擎如百度、谷歌、搜狗、360搜索、神马等都有多个蜘蛛同时异步并发工作,以增量蜘蛛为主,垂直蜘蛛和深网蜘蛛为辅。

抢夺入场

蜘蛛爬取数据需要一个起点,即入口。 从指定的入口开始,它们在整个网络上开始了永无止境的爬行之旅。

蜘蛛爬行的主要入口有:

(1)平台手动输入的种子网站。 初始种子网站一般是高权重网站、知名导航网站、大型DNS服务器网站等,如网易官网、人民网等。

(2)站长主动提交的网址。 新网站可以主动告诉搜索引擎URL,这样可以提高被抓取的速度。 百度、360、搜狗、谷歌等搜索引擎都有专门的提交入口。 对于一些私人暗网,搜索结果只能等待入口主动提交。

百度链接提交入口:

360搜索引擎登录入口:

搜狗网站采集提交入口:

网站收录及提交入口:

抓取策略

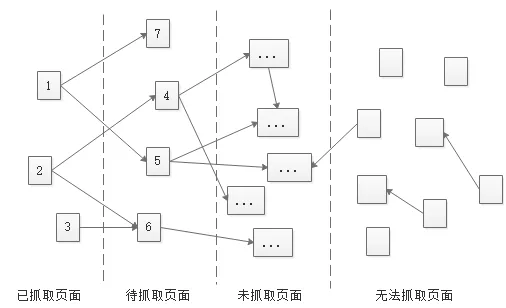

互联网上几乎有无限的页面。 为了在有限的服务器资源下尽可能高效地抓取网页,蜘蛛会采取多种策略。 在蜘蛛眼中,互联网上的页面分为已爬行页面、待爬行页面、未爬行页面和不可爬行页面。

为了提高工作效率,蜘蛛程序会建立已爬行页面列表和待爬行页面列表。 已爬取的页面将进入已爬取列表,新发现的页面将进入待爬取页面列表。 未爬取的页面是指尚未被发现的页面,但链接是打开的,迟早会被爬取。 无法抓取的页面是指因链接被屏蔽而无法访问的页面,例如暗网。

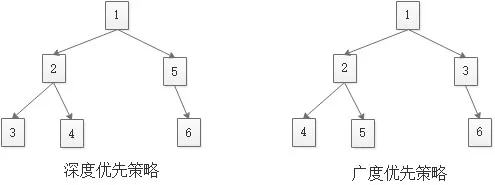

当蜘蛛分析一个页面并发现许多新链接时,它面临一个选择:是先进入第一个新发现的页面,还是继续注册新发现的第2、3、4……页面。

深度优先策略是沿着深度爬行,直到知道无法再继续前进并返回到上一个同级页面。 广度优先策略是分批分层爬取。 如果服务器资源不受限制,理论上两种策略的最终结果是相同的。 但实际上,服务器资源是优先的,需要尽可能快速、高效地爬行。 一般采用广度+深度的综合爬取策略。

除了深度优先策略和广度优先策略外,还有PR优先策略、反链接策略、社交分享引导策略等,每种策略都有自己的优缺点。 在实际情况中,往往会组合使用多种策略来达到最佳的抓取效果。

从功能和重要性的角度来看,蜘蛛会优先爬行权重高的网站以及网站的重要页面。 权重高的网站一般具有内容丰富、结构良好、权威值得信赖等特点,特别照顾有利于整个网络的抓取效率。 网站的重要页面指的是首页和目录页,它们比内容详情页更有优势。

:: 本节知识点吸取优化经验。 (1)多个外部链接,尤其是高质量的外部链接,可以建立和缩短蜘蛛爬行路径,提高网页优化效率; (2)网站首页和目录比内容详情页更重要。 ,流量较大,首页上的登陆页面应尽量放在首页,然后是目录页。

更新策略

除了不断地抓取新的页面之外,蜘蛛的另一个任务就是更新抓取到的页面。 当蜘蛛再次爬行时,更新策略的主要依据是什么?

1、用户行为体验

用户行为体验是指页面结构、点击率、评论率、评论数等。干净的界面结构和快速的加载速度是优点; 点击率高、用户评论率高、解决用户需求的概率大为优势; 大量评论、点赞、收藏等互动是优势。

2、网站内容质量

搜索引擎非常重视用户体验,喜欢持续产生原创内容网站,因为这对网络价值贡献很大。

3.历史更新频率

蜘蛛每次访问一个页面时,都会记录页面的更新。 如果页面长时间不更新,蜘蛛几次之后就基本不再访问了。 如果蜘蛛每次访问一个页面时,都会更新该页面的内容,并且定期更新,那么蜘蛛就会适应这种更新模式,并尝试匹配爬行的模式,以提高其工作效率。

4.页面权限

内容丰富的大型网站和权威网站将受到特别关注。 此外,政府部门网站、认证品牌官方网站、甚至注册网站一般都会频繁更新。 搜索结果基于网站链接的权重和信任度,高质量网站的外部链接非常有效。

5.网页类型

整个网络上的网页类型非常有限,蜘蛛可以轻松识别每种网页类型。 网页类型包括网站首页、目录页、主题页、内容详情页,蜘蛛对其更新的频率依次递减。

:: 这部分是SEO优化的重要组成部分。 只有掌握了它,才能做好网站排名优化工作。 另外,对于更新特别慢的页面,可以通过主动推送、手动提交、自动推送的方式提交链接。 您还可以尝试使用百度站长平台的“抓取诊断”工具进行抓取,这将有助于百度快速更新。

蜘蛛和普通用户的区别

虽然搜索引起的蜘蛛程序尽最大努力模拟正常用户访问网页,但仍然存在一些差异。 熟悉它们之间的区别对于SEO优化非常有帮助。

1、蜘蛛可以识别网页是否含有隐藏信息、是否存在黑色链接等,但普通用户一般无法识别。

2. 蜘蛛目前无法读取和识别JS、Ajax、图片和Flash内容,但普通用户可以。

3. 不存在蜘蛛访问,但普通用户存在。

4、蜘蛛无法注册网址,也无法访问注册后才能使用的页面(如下单、支付),但普通用户可以。

5. 蜘蛛不会读取被URL配置阻止的页面,但普通用户会。

6、蜘蛛抓取动态参数的界面可能会陷入死循环(比如万年历),但普通用户不会。

7、蜘蛛无法直接访问网页,但普通用户可以直接访问网页。

客户端可以指定资源的URI来自哪个请求地址。 请求头可以让服务器获取所请求资源的来源,可以用来分析用户的兴趣爱好、收集日志、优化缓存等,也可以让服务器检测到过时的、错误的链接,并对其进行维护。及时地。 通过查找您网站上的死链接、跟踪错误或找出用户用来查找您网站的搜索词。 它还可以用于增强安全性:检查标头是防止跨站点请求伪造的一种方法。

:: 熟悉本节内容可以大大提高网络安全。 如果掌握了这些技术,理论上就可以攻击和防御。 我们呼吁大家遵守互联网行为规范,使用正规的SEO优化方法自然排名在首页。 只要能抓住要点,有基础的话(内容有规律、有更新),经过2到7天的SEO优化后上首页问题不大。

扫一扫在手机端查看

我们凭借多年的网站建设经验,坚持以“帮助中小企业实现网络营销化”为宗旨,累计为4000多家客户提供品质建站服务,得到了客户的一致好评。如果您有网站建设、网站改版、域名注册、主机空间、手机网站建设、网站备案等方面的需求,请立即点击咨询我们或拨打咨询热线: 13761152229,我们会详细为你一一解答你心中的疑难。

客服1

客服1